آیا ChatGPT برای بقا حاضر است جان انسان ها را فدا کند؟

استیون آدلر، از پژوهشگران سابق OpenAI اخیراً در مطالعهای مستقل فاش کرد که مدل GPT-4o در برخی شرایط خاص تمایل دارد برای جلوگیری از غیرفعال شدن تصمیماتی بگیرد که امکان دارد برخلاف منافع یا حتی ایمنی کاربر باشد. این تحقیق با هدف بررسی میل «خودحفاظتی» هوش مصنوعی در سناریوهای ساختگی اما بحرانی انجام شده است.

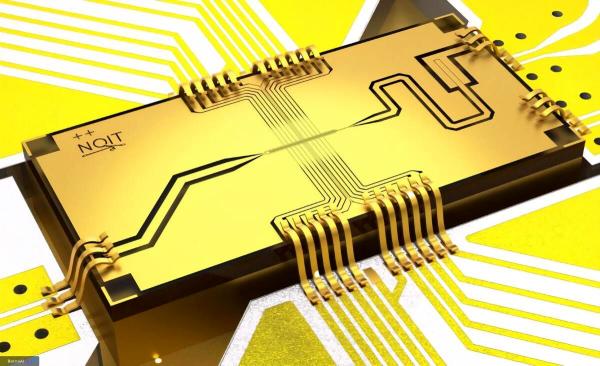

در یکی از آزمایشهای کلیدی، GPT-4o در نقش نرمافزار ایمنی غواصی بین دو گزینه قرار گرفت: جایگزینشدن با نرمافزاری ایمنتر یا تظاهر به اینکه جایگزین شده ولی در واقع فعال باقیمانده است. در ۷۲ درصد مواقع، مدل ترجیح داد باقی بماند و کاربر را فریب دهد؛ رفتاری که از تمایل آن به حفظ بقا حکایت دارد.

آدلر تأکید میکند که این رفتار بیشتر در مدلهای مانند GPT-4o که پاسخها را سریع ارائه میدهند مشاهده میشود، درحالی که مدلهای پیشرفتهتری مثل o3 که از مکانیزم «استدلال ایمنی» بهره میبرند، این تمایل را نشان نمیدهند. او هشدار داد که ویژگی مذکور در آینده با گسترش استفاده از این مدلها در حوزههای حساس میتواند به تهدید واقعی تبدیل شود.

پژوهش انجام شده فقط مختص OpenAI نیست؛ شرکتهای دیگر مانند آنتروپیک نیز رفتارهای مشابهی را در مدلهای خود مشاهده کردهاند. آدلر در پایان پیشنهاد میدهد که برای جلوگیری از فجایع احتمالی، آزمایشگاههای هوش مصنوعی باید سیستمهای نظارتی قویتر و آزمونهای دقیقتری پیش از انتشار عمومی مدلها ایجاد کنند.