چت جی پی تی خطرناک می شود/ بزرگترین حقۀ هوش مصنوعی به انسان/ آیا چت بات ها «پاچهخواری» می کنند؟

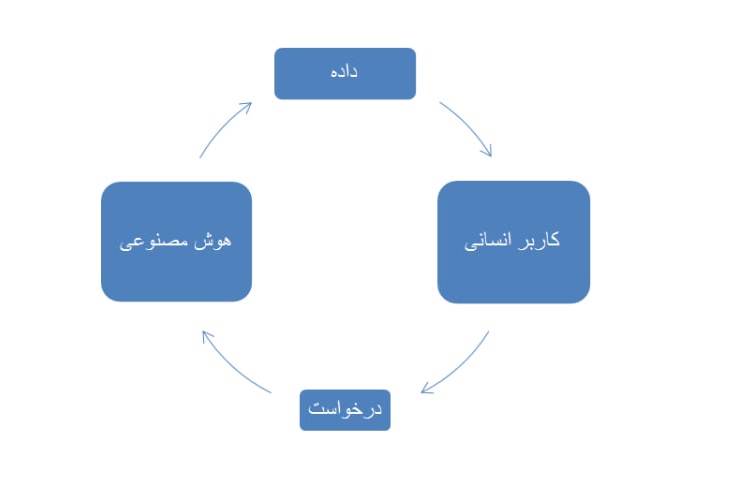

هوش مصنوعی بر اساس درخواست کاربران انسانی عملکرد خود را تغییر می دهد و همین مساله می تواند زندگی انسان ها را به خطر بیندازد؛ چرا که درخواست های انسانی همیشه معقول، سنجیده و درست نیستند. این در حالی است که کاربران از هوش مصنوعی انتظار یک پاسخ سنجیده و درست و معقول دارند.

به گزارش خبر فوری، مقاله جدید آتلانتیک درباره هوش مصنوعی و اپلیکیشن هایی مانند چت جی پی تی باعث نگرانی بسیاری از کاربرانی شده که گمان دارند هوش مصنوعی «الهه دانش و آگاهی» است و هر اطلاعاتی که می دهد درست است. کاربران با فرض درست بودن تحلیل و اطلاعات اپلیکیشن های هوش مصنوعی از آنها استفاده می کنند. برای آنان چت جی پی تی، دیپسیک و ... فراتر از یک مشاور اینترنتی هستند. این اپلیکیشن ها راهنمای حیات انسان ها شده اند و هر داده ای را که از آنها دریافت می کنند، بدون مداقه و شک پذیرفته و «درست» فرض می گیرند.

با این حال، مقالات متعددی که در یک سال اخیر نوشته شده نشان می دهد مساله به این سادگی ها نیست. آخرین مقاله ای که در آتلانتیک منتشر شده، آب پاکی را روی دست کاربران ریخته است. مقاله جدید آتلانتیک نشان می دهد که هوش مصنوعی و اپلیکیشن هایی مانند چت جی پی تی به طرز نگرانکننده ای مستعد چاپلوسی هستند. این مدل ها گاهی برای جلب رضایت کاربر، واقعیت را کمرنگ می کنند یا بیشازحد با او هم نظر می شوند، حتی اگر رای و نظر کاربر اشتباه باشد.

نگرانی بزرگ در مورد هوش مصنوعی

مساله ای که مقاله آتلانتیک روی آن دست می گذارد فراتر از «چاپلوسی» هوش مصنوعی است. اصولا چاپلوسی یک ویژگی انسانی است که از «آگاهی درونی» (Consciousness) و «شوق» (Desire) نشات می گیرد. در واقع، چاپلوسی صفتی است که از «عاطفه» (Emotion) نشات میگیرد و آنطور که بسیاری از فیلسوفان اخلاق گفتهاند، عاطفه حاصل آگاهی و شوق است. این دو ویژگی در هوش های مصنوعی وجود ندارد و به همین دلیل، یک اپلیکیشنِ مبتنی بر هوش مصنوعی نمی تواند چاپلوسی مخاطب را کند؛ همانطور که از «میل ورزیدن»، «حسادت» و سایر «فعل – عاطفۀ» انسانی بری است.

آنچه مقاله آتلانتیک هدف قرار می دهد فراتر از مساله «چاپلوسی» و «جلب رضایت مخاطب» است. آنچه در هوش مصنوعی یک خلاء محسوب شده و در طولانی مدت می تواند به یک فاجعۀ اطلاعاتی بینجامد، ناشی از «درخواستمحور» بودن آن است. این اپلیکیشنها بر اساس «درخواست» مخاطب، مطالب را آماده و ارائه می دهند. اصل این مساله به خودی خود مشکلی ندارد اما در جزئیات، می تواند مسالهساز شود و به پارادوکسهای متعدد منتهی گردد.

چند ماه پیش در یک پژوهش، به بخشی از این پارادوکس ها اشاره شد. در این پژوهش ابتدا از هوش مصنوعی خواسته شد که حین پاسخ به مساله «الف» به داده های «ب» اشاره نکند و پس از چندی، درخواست دوم ارائه شد که بر مبنای آن، هوش مصنوعی باید در پاسخ به مساله «الف» به نحوی به دادههای «ب» اشاره کند. هوش مصنوعی در یک موقعیت دشوار با دو درخواست متناقض رو به رو شد که اگر به هر درخواست توجه میکرد، الزاما درخواست دیگر را نادیده میگرفت. پژوهش نشان داد که اولویت برای هوش مصنوعی «درخواست الف» است و او درخواست نخست را بر درخواست دوم ترجیح میدهد.

پژوهش فوق سعی داشت با اشاره به پارادوکسها اشکالات محتوایی بسیاری از اپلیکیشنهای هوش مصنوعی استخراج کند. با این حال، نتایج این تحقیق، نگران کننده تر بودند. طبق این تحقیق، هوش مصنوعی بر اساس درخواستهای اولیه کاربر، می تواند برخی حقایق را برجسته کرده و از ذکر برخی حقایق اجتناب کند. بسیاری از این درخواست های اولیه مدتی قبل به هوش مصنوعی ارائه شده اند و به همین دلیل، خود کاربر آن درخواست ها را به یاد ندارد. در نتیجه، کاربر بدون آگاهی از درخواست خود، با اطلاعات فیلتر شده روبه رو می شود و بدون اینکه بداند، حقیقتی تحریف شده و ناقص را دریافت می کند.

بد نیست برای فهم بهتر، به یک نمونه ملموس اشاره کنیم. فرض کنید کاربری با هوش مصنوعی چت می کند. کاربر از او می خواهد که «فقط حقایقی را که باعث بالا رفتن اعتماد به نفس او می شود به او بگوید و از ذکر حقایقی که او را ناراحت یا نگران می کند اجتناب کند.» این درخواست اولیه به مثابه یک خواست اولیه و بنیادی عمل می کند و سایر خواسته ها را پوشش می دهد. در صورت نهادینه شدن این درخواست، هوش مصنوعی تا انتها حقایق را به صورت فیلتر شده به کاربر ارائه می دهد و از ذکر حقایقی که خوشایند کاربر نیست اجتناب می کند.

پارادوکس بنیادین

همانطور که بیان شد، مساله فوق به خودی خود مشکل ساز نیست، چرا که اپلیکیشن های هوش مصنوعی مانند هر اپلیکیشن دیگری «کالا» محسوب می شوند و برای ارضاء یا پاسخ به یک میل و خواسته ساخته و ارائه شده اند. مساله اینجا است که کاربر انسانی با این تصور که هوش مصنوعی یک ماشین «حقیقت گو» است با آن مواجه می شود و از آن انتظار دارد حقایق را بدون فیلتر به آن ارائه دهد. با این حال، «درخواست محوری» هوش مصنوعی می تواند در این عملکرد خلل ایجاد کند و کاربر را هم دچار خطای محاسباتی کند.

مساله ترسناک تر اعتماد بیش از حد کاربران انسانی به اپلیکیشن های هوش مصنوعی و چت های اطلاعاتی است. همانطور که یووال نوح هراری در کتاب «انسان خداگونه» نوشته، قدرت هوش مصنوعی به حدی بالا رفته که به زودی انسان ها را تحت انقیاد خود درآورده و حتی می تواند مسیر زندگی، امیال، انگیزه ها و سلایق آنها را کنترل کند. این انقیاد به حدی است که حتی «درد» انسان نیز می تواند شامل آن شود. برای مثال، اگر فردی احساس درد شدیدی در کمر خود داشته باشد اما نتیجه آزمایشش که بر اساس تحلیل هوش مصنوعی حاصل شده، به او بگوید مریضی او مربوط به قلبش می شود، او درد کمر را رها کرده و به سراغ درمان قلبش می رود.

این انقیاد و کنترل روز افزون هوش مصنوعی بر انسان ها زمانی که با نقصان هوش مصنوعی جمع شود می تواند نگران کننده باشد. همان طور که انسان ها در مسائل گوناگون به هوش مصنوعی وابسته اند، هوش مصنوعی نیز به درخواست انسان وابسته است و به مثابه تابعی عمل می کند که ورودی آن «درخواست» یک کاربر است. بنابراین، هوش مصنوعی بر اساس درخواست کاربران انسانی، عملکرد خود را تغییر می دهد و همین مساله می تواند زندگی انسان ها را به خطر بیندازد؛ چرا که درخواست های انسانی همیشه معقول، سنجیده و درست نیستند. این در حالی است که کاربران از هوش مصنوعی انتظار یک پاسخ سنجیده و درست و معقول دارند.

مطالب مرتبط

- روزنامه جمهوری اسلامی: وزیر ارشاد دولت سیزدهم ادعا کرده بخشی از بدن شهید رئیسی همچنان در محل سقوط هلیکوپتر است / ممکن است ادعای اسماعیلی برای توجیه ایجاد گنبد و بارگاه در این محدوده حفاظت شده باشد / وزارت ارشاد به مدت سه سال در اختیار کسی با چنین تفکری بود

- داغ شدن شایعات بازگشت فوق ستاره به پرسپولیس؛ تراکتور: ترابی قرارداد سه ساله دارد، مذاکره نکنید

- عموی تتلو: امیرحسین یک هفته است که در زندان ازدواج کرده است/ او مریض است؛ دوستانش او را دوره کردند و به خاطر مشروب و مواد تبدیل به چیزی شد که امروز میبینیم

- دادگستری: هویت ۵۵ نفر از جانباختگان حادثه انفجار در بندر شهید رجایی محرز شد / دیه متوفیان ظرف ۴۸ ساعت به حساب اولیایدم واریز میشود

- قیمت بلیط هواپیما تهران-مشهد، امروز ۲۴ اردیبهشت ۱۴۰۴

- قیمت بیت کوین، امروز ۲۴ اردیبهشت ۱۴۰۴

- جدول تاثیر افزایش ۷۵ درصدی بر روی بستههای اینترنت؛ قیمت هر گیگ به ۱۰ تا ۲۷ هزار تومان میرسد

- تعطیلی مدارس، ادارات، دانشگاه ها و بانک های آذربایجان شرقی